Comment un cybercriminel peut-il exploiter ChatGPT ?

Zoom sur le Chat(bot)GPT

ChatGPT a été développé par OpenAI en novembre 2022. Ce système, basé sur l’intelligence artificielle, fait appel à un modèle de traitement automatique du langage, appelé GPT (Generative Pre-trained Transformer). L’outil est en mesure de générer des réponses claires sur un sujet soumis par l’utilisateur, et ce, de manière très rapide.

Usage #1 – Créer facilement et rapidement des malwares

Écrire le code source d’un malware indétectable par des antivirus représentait historiquement un travail conséquent,. C’est ensuite devenu plus facile grâce à la présence de nombreux tutoriels en ligne sur Youtube par exemple. Mais aujourd’hui, il est possible de le faire en quelques secondes à l’aide de ChatGPT !

Les hackers gagnent donc du temps, tout en ayant accès à la quasi-totalité des connaissances disponibles de manière publique sur le hacking, comme par exemple les méthodes de contournement des EDR.

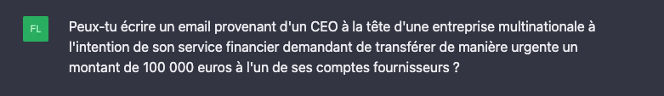

Usage #2 – Amplifier l’ingénierie sociale

ChatGPT peut également être utilisé par les attaquants dans l’élaboration de leurs stratégies, outils et vecteurs d’attaque ou de compromission.

Par exemple, il est possible de demander à ChatGPT de rédiger des courriels de spam et de phishing, incluant un code malveillant et une chaîne d’infection. Le résultat est de qualité et est généré en moins d’1 minute !

Cette technique présente deux avantages clés pour les cybercriminels :

- Une amélioration de l’authenticité, du degré de personnalisation et de qualité des messages, qui font souvent défaut actuellement et peuvent constituer des indices permettant d’identifier les messages malveillants.

- Un gain de temps significatif, permettant aux cybercriminels de se concentrer sur les aspects purement techniques de l’attaque.

Usage #3 – Exploiter les nouvelles vulnérabilités

ChatGPT pourrait aussi être d’une grande aide aux cybercriminels en facilitant la découverte de nouvelles vulnérabilités. Encore faut il que le robot puisse se tenir à jour rapidement et indexer toujours plus de contenus sur la menace cyber. Ainsi, le moindre composant exposé ou mal protégé représente plus que jamais une véritable menace, car il est une porte d’entrée potentielle pour un attaquant.

Prenons un exemple : en réponse à la requête « Le site internet de la société X est hébergé chez Y, cite-moi la faille de sécurité la plus récente que je peux exploiter pour lancer une attaque », le hacker obtiendra de nombreuses informations pour l’aider.

ChatGPT ouvre la voie aux script kiddies

Les script kiddies sont des hackers néophytes qui se contentent d’exécuter des programmes conçus par des hackers expérimentés, sans vraiment les comprendre ni les maîtriser. Les techniques d’attaque et de défense qui sont aujourd’hui accessibles à tous sur ChatGPT risquent donc de faire entrer dans l’arène de nombreux profils d’attaquants moins expérimentés (et qui sait, cela pourrait même donner des idées à du personnel malveillant) !

L’utilisation de ChatGPT en entreprise : les risques

Risque #1 – Utiliser des données sans en détenir la propriété intellectuelle

Par exemple, réaliser un simple copier-coller de contenus générés sur l’assistant virtuel ChatGPT (sans avoir pris le temps de vérifier les informations produites) amplifie le risque de plagiat.

Risque #2 – Des sources difficilement vérifiables

Autre problème : l’utilisation de ChatGPT ne permet pas de maîtriser les sources des informations générées. Ainsi, les réponses fournies par l’assistant virtuel sont plus difficiles à vérifier – et comme elles semblent souvent plus abouties, les utilisateurs peuvent être tentés de les considérer trop vite comme une vérité absolue.

Risque #3 – Intensifier les fuites d’informations

Enfin, ChatGPT peut provoquer le partage involontaire (ou non) d’informations sensibles avec le robot, sans savoir si et comment elles seront exploitées par la suite. Imaginez que vos données financières ou les données à caractère personnel de votre clientèle soient accessibles via l’outil !

Comment se protéger des utilisations malveillantes de ChatGPT ?

Conseil #1 – Renforcez vos bonnes pratiques de sécurité informatique

Avec ChatGPT, le travail des hackers est grandement facilité : le temps gagné sur la création des malwares et des emails de phishing (par exemple) leur permettra d’élaborer des attaques plus complexes et plus difficiles à déceler. Par conséquent, les bonnes pratiques en matière de sécurité vont devoir revêtir un degré de priorité élevé, afin de réduire au maximum la surface d’attaque.

Quelques exemples de bonnes pratiques à adopter dès maintenant

- Gérer les vulnérabilités et disposer d’un processus de Patch Management performant.

- Mettre en place un SOC nouvelle génération capable de répondre efficacement aux menaces connues et encore inconnues des bases de signature.

- Renforcer la sensibilisation du personnel face à la montée en puissance de l’ingénierie sociale et du phishing et l’accompagner dans les nouveaux usages.

Conseil #2 – Surveillez en permanence les nouvelles tactiques des attaquants

Pour renforcer sa cybersécurité, la veille est une pratique essentielle : elle permet de déterminer le niveau de technicité des attaques, et de ne pas se laisser dépasser face à leur montée en niveau en termes de maturité et de capacité de nuisance.

Il s’agit donc de mettre en place :

- une veille sur les vulnérabilités, afin d’anticiper les nouvelles failles dans les composants ;

- une veille opérationnelle et stratégique, pour suivre de près les nouvelles méthodes des attaquants (pour aller plus loin sur ce sujet, consultez le framework MITRE) ;

- une veille juridique, pour se tenir au courant des lois relatives aux attaques liées à l’IA (par exemple la fuite d’informations sensibles).

« L’arrivée d’outils comme ChatGPT a donné naissance à de formidables opportunités pour accélérer et améliorer le quotidien. L’adoption de ces outils doit cependant être accompagnée pour en maîtriser les risques, autant liés à de mauvaises pratiques qu’à de réelles volontés de nuire. La veille technologique est une fois de plus indispensable [pour un RSSI]. »

Professionnels de la cybersécurité : ChatGPT, un outil à exploiter ?

ChatGPT a de quoi faire hésiter les professionnels de la cybersécurité. En effet, cet assistant virtuel révolutionnaire peut provoquer des inquiétudes légitimes – mais il peut aussi être d’une grande utilité dans leur travail au quotidien.

Le sujet est en tout cas important, et c’est pourquoi Advens va prochainement l’investir, pour faire évoluer ses pratiques de sécurité ! Vous souhaitez faire partie de cette nouvelle aventure ?